Asahi Kobori

@kbrash_

Software Engineer / Immersive Video Engineering / Co-Founder & CTO @_amplium / Ridiculous goals are ridiculous right now but it’s not forever.

人生(エンジニアは特に)は、世界の動きに合わせて自分を変えていかないと行けないので、やはり変化できない人から人生がキツくなっていくのはそれはそう

generateMipmapsと同等の処理をfragment shaderでやりたかったらどうやるの〜、初心者すぎてわからない developer.apple.com/documentation/…

Supabase便利なんかなって思ってたけど、結局RDSをプライベートネットワークに置いてEC2にインストールしたHasura経由でGraphQLする方が安全か〜。Prismaでスキーマ管理もしやすいし。

再度、告知しておこう。バイブコーダーはフロントエンドでSupabase使うのはやめようね。それ、普通にバックエンド作るよりかえって難しいから。

Claude Code、あまり詳しくない分野のことをやらせる時はスラスラと書いてくれて助かるってなるけど、詳しい分野についてやらせる時は手取り足取り指導しないとゴミしか出てこないので、詳しくない分野では詳しくないから気づかないだけでゴミを量産しているだけの可能性が全然ある

Claude Codeと一ヶ月ちょっと向き合ってきて、AIの手数の力でとりあえずどんどん作ってみる、みたいなやり方は中期的にはあまりうまく回らないなー、という考えになってきてる。…

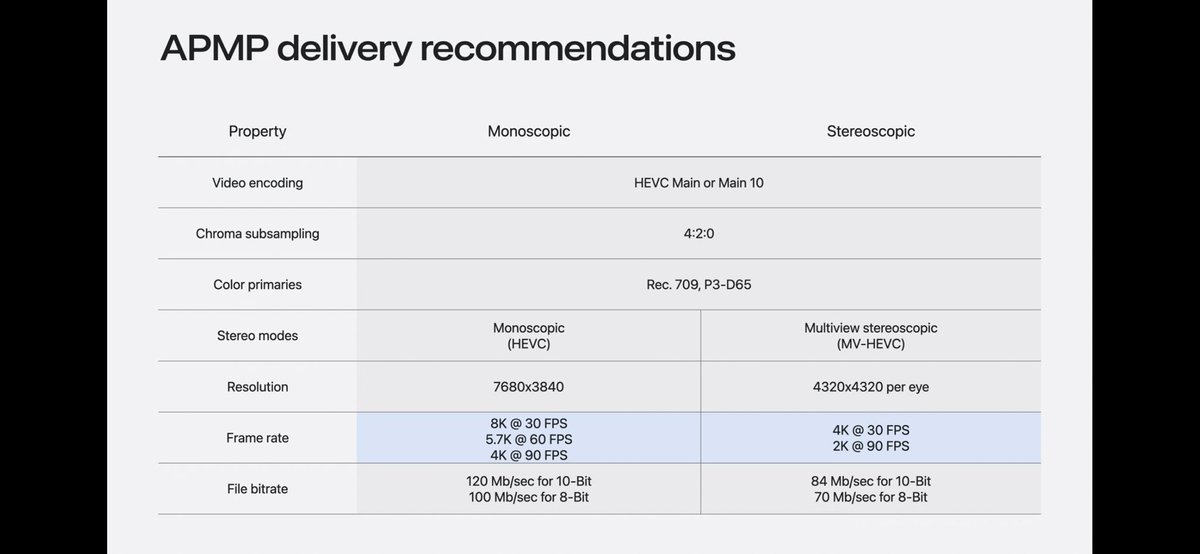

APMPにこだわる必要ないんじゃね?普通に超高クオリティなMV-HEVCを流せばいいだけじゃん。 技術にこだわりすぎない。大事。

今後ますます重要になるのが、「AIネイティブな会社・人」です。つまり、AIを“部分的に“取り入れるのではなく、最初から“AIありき“で全体を再設計しているという意味です。 こういった考え方が、今後は標準になっていくし、Microsoftはまさにその方向に本気で舵を切ろうとしているのです。…

一年前の都知事選の終わりは、チームみらいの始まりでした。あの時の15万4638票がなければチームみらいをはじめることはできませんでした。都知事選のときの全く無名だった私を見つけていただいた15万4638人のみなさま、本当にありがとうございました。…

DisplayLinkって画面レンダリングの使用例でよく見るけどメインスレッドの忙しさや外部環境によって、狙ったフレームレートでループがこないことが多いので、誤解を恐れずに言うと全然使えない。

あまり詳しくないけど、今のスマホ上で動くAIアプリって基本的にはインターネット先のLLMのAPIを叩かないといけない。 でも2、3年後にスマホ上でo3 miniぐらいのAIがオフラインで動いたら、ユーザーに課金させる料金をグンっと下げることができる。

URSA Cine Immersiveの.aimeファイルからキャリブレーション情報を取り出し、MacOS26のAPIと自作metalを組み合わせて魚眼映像をEquirectangleに変換。 レンズのキャリブレーション情報からマッピングしてるので、正しい変換できている、、はず、、

Apple公式は両目で8K/30FPS or 4K/90FPSをレコメンドしてるけど、Ampliumでは絶対に16K/90FPSで再生してみせる

Parametric Immersiveは内部でレンズごとのEquirectangleへの変換値を持つのが目的でそれを使ってVisionOS26内部でFisheyeから変換してるだけっぽい。 もしこれが合ってるならそんなエッジデバイスでGPU負荷上げるようなことしなかったら良いのに クリエイターさん向けに利便性優先ってことなんかな

本当にイノベーションを起こすときって全員のコンセンサスを取ってたら間に合わないんだなと思った。 優秀なエンジニアは自分の情熱に従って勝手にイノベーティブなものを作るし、もちろん失敗も多いんだろけど、その分、手を動かすスピードもめっちゃ早い。 m.youtube.com/watch?v=mPWzFf…