Taiji Suzuki

@btreetaiji

統計科学・機械学習・数理工学を研究してます.

Thrilled to introduce "𝗗𝗲𝗲𝗽 𝗥𝗲𝘀𝗲𝗮𝗿𝗰𝗵𝗲𝗿 𝘄𝗶𝘁𝗵 𝗧𝗲𝘀𝘁-𝗧𝗶𝗺𝗲 𝗗𝗶𝗳𝗳𝘂𝘀𝗶𝗼𝗻," a new deep research agent designed to mimic the iterative nature of human research, complete with cycles of planning, drafting, and revision. 🚀🚀 arxiv.org/pdf/2507.16075

少し遅いアナウンスですが,日本評論社から出版中の「数学とAIのこれまで(とこれから)」に以前執筆した記事「生成AIの数理」+後日談が掲載されています. その他の豪華な先生方の記事も大変勉強になります.

ChatGPT can now do work for you using its own computer. Introducing ChatGPT agent—a unified agentic system combining Operator’s action-taking remote browser, deep research’s web synthesis, and ChatGPT’s conversational strengths.

arxiv.org/abs/2507.10532 これが本当なら、残念ながらQwen系の強化学習論文の信憑性は完全に無くなってしまった。 つまみ食い程度しかAI系の論文を読んでない自分ですら、QwenがLlamaよりも強化学習で数学の能力が上がる結果を見たことあるから、多くの研究者がQwen使ってたんじゃないかな。残念

Can transformers analyze code efficiently? ✅ Yes. We prove transformers efficiently handle real compiler tasks (AST construction, symbol resolution, type infer) using only log size—while RNNs require linear size (in input length). Paper: arxiv.org/abs/2410.14706 #COLM2025

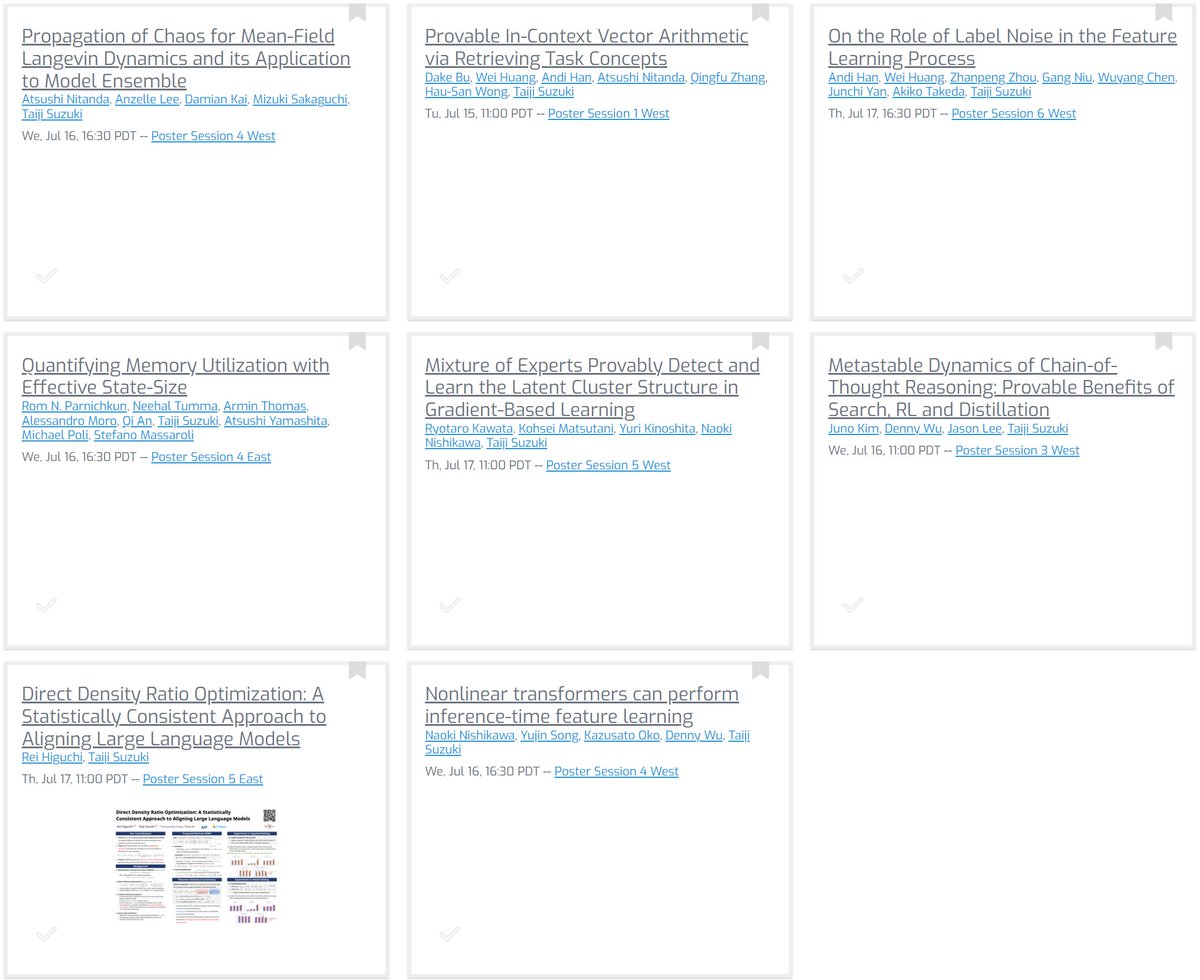

Unfortunately, I cannot attend ICML this year. But, my students and collaborators will present our work in the main conference. Please stop by our posters!

Google’s Gemini 2.5 paper has 3295 authors arxiv.org/abs/2507.06261

Google’s Gemini paper has ~1000 authors arxiv.org/abs/2312.11805

文脈内学習の状況にて,Transformerはsoftmax注意によって「テスト時に」特徴学習ができることを示しました.さらに,そのテスト時の学習複雑さは情報理論的下限に近いレートを達成し,「生成指数」と呼ばれる量で特徴づけられることを示しました.ICML2025で発表します. x.gd/WXBCy

BioEmu is now published in Science! 🎉 I’m deeply grateful to the incredible highly collaborative team that made this happen. Can't wait to see how the community uses BioEmu to better understand protein structure ensemble and their implilcations in biology and medicine.

Today in the journal Science: BioEmu from Microsoft Research AI for Science. This generative deep learning method emulates protein equilibrium ensembles – key for understanding protein function at scale. msft.it/6010S7T8n

Mixture of Expertの学習ダイナミクスに関する研究がICML2025に採択されました.インターンの松谷君(当時B3!)と弊研究室M1の川田君主導の研究です. 単一ネットワークでは学習が難しい問題でも,ゲートネットも一緒に学習することで学習可能になることを示しています. x.gd/hDIW3

LLM訓練時にデータを説明するメタデータを挿入することで学習効率が変わるのかを調べた東大鈴木研とPFNの共同研究がCOLM 2025に採択されました。学習効率を改善する利点が大きいが、隠れた情報を推定する能力を学習する機会が失われ、後続タスクの条件次第でトレードオフがあることを示しました

訓練時に文章の文頭にmeta-dataを挿入することで学習の効率がどのように変化するかを調べた研究がCOLM2025に採択されました.PFNの方々と共同研究させていただきました. arxiv.org/pdf/2504.17562

D2の西川君による研究です. 通常のAttentionを線形Attentionに蒸留する際に,必要な次元を統計的自由度を用いて決定する手法を提案しています.各層の"複雑さ"を定量化することができて,次元を決め打ちするよりも効率的な近似が可能です.

新しい論文を arXiv にアップロードしました。 線形 Attention は、LLM をはじめとする基盤モデルの Attention を近似し、推論を高速化する手法です。この研究では、Attention を線形 Attention に蒸留する際の次元選択の方法を、統計理論の道具を使って提案しました。 arxiv.org/abs/2507.03340

訓練時に文章の文頭にmeta-dataを挿入することで学習の効率がどのように変化するかを調べた研究がCOLM2025に採択されました.PFNの方々と共同研究させていただきました. arxiv.org/pdf/2504.17562

Our paper on metadata conditioning in LM pretraining arxiv.org/abs/2504.17562 is accepted to CoLM 2025! Huge thanks to all coauthors and reviewers!

今回のNeurIPSの査読ルール,かなり効いている(査読を提出しない査読者には共著者にメールが行く&自分の論文の査読結果が見られなくなる).すべての論文で査読が揃っている.これまでにはあり得なかった現象.

Very excited to see this agreement. I was able to tour @CFS_energy's facility in December last year and was excited by the potential! Working fusion energy could be game changing for the world.

Historic news for CFS: We’ve signed a landmark agreement with @Google, a multifaceted partnership that dramatically advances our commercial fusion energy mission: ⚡️Google signed an offtake agreement for 200 megawatts of power from our first ARC power plant ⚡️Google is…

You don’t need a PhD to be a great AI researcher, as long as you’re standing on the shoulders of 100 who have one.

You don’t need a PhD to be a great AI researcher. Even @OpenAI’s Chief Research Officer doesn’t have a PhD.